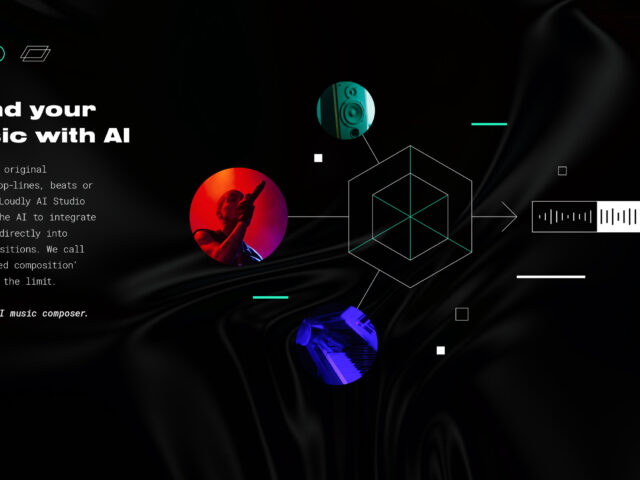

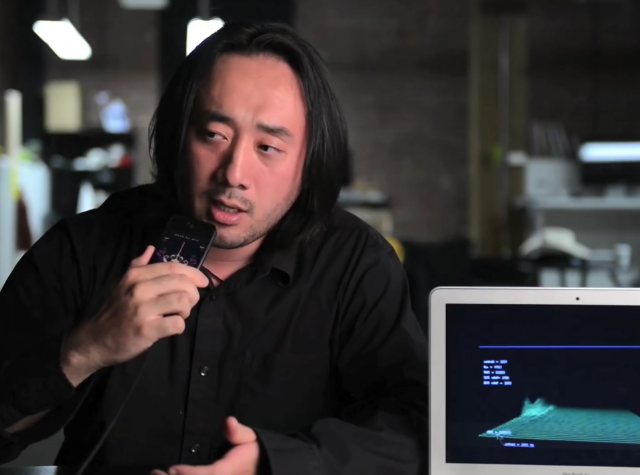

Google和日本大阪大學發表一項將思想轉化為音樂的技術的研究。

Google和日本大阪大學徵求了五名志願者進入 fMRI(功能性磁共振成像)掃描儀中,

在這當中播放了 10 種音樂風格的 500 多首不同曲目作為刺激,得到了一些有趣的結果。

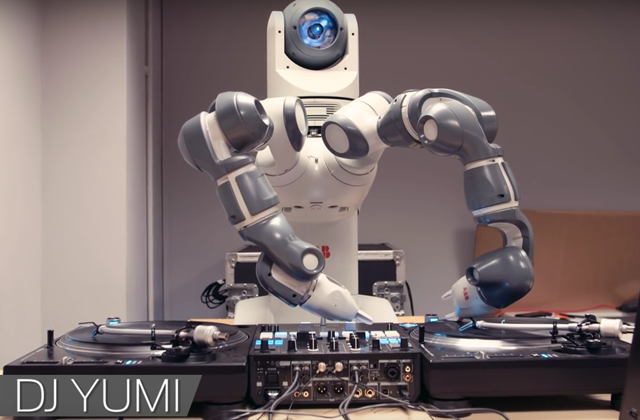

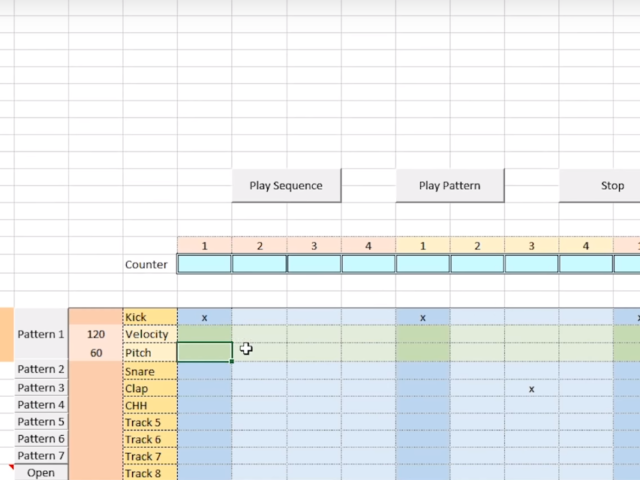

五名志願者大腦受到刺激後會創建圖像,被捕捉到的大腦活動圖像被輸入到名為 Brain2Music 的人工智能模型中,該模型學會使用Google的人工智能音樂產生器 MusicLM 創作與受試者正在聽的歌曲類似的歌曲。

研究人員表示,下一步將是使用人工智能純粹根據某人的想像力而不是特定的音樂刺激來生成音樂。

當然,距離心靈感應 DAW 的出現還有一段路要走——除非你的臥室工作室裡碰巧有一台功能磁共振成像掃描儀。

整篇研究論文可在康奈爾大學的免費在線學術文章檔案庫 arXiv 上取得。

About the Author: tooltour

Related posts

透過Carl Cox和Martin Garrix的雙眼看電子音樂 – What We Started電子音樂紀錄片

What We Started 紀錄片主 ...

第39屆NAMM TEC 技術獎DJ類由Traktor 軟體拿下

NAMM 秀在2023年底時已經公布了所 ...

台灣首團Scratch文化推廣組織 – T-Knife Factory專訪

前言: 這2年其實很開心可以再稍微看到越 ...

Moog Music 將併入 inMusic 家族,和 Akai Pro、Alesis 和 M-Audio 同為同一集團成員!

Moog Music 將併入 inMus ...

商品

-

AKAI - MPC Studio 2 取樣器

NT$8,800

AKAI - MPC Studio 2 取樣器

NT$8,800

-

UDG Ultimate 可調式 筆電/器材架 黑...

NT$2,780

UDG Ultimate 可調式 筆電/器材架 黑...

NT$2,780

-

UDG Ultimate 可調式 筆電/器材架 白...

NT$2,780

UDG Ultimate 可調式 筆電/器材架 白...

NT$2,780

-

RANE SEVENTY A-TRAK 混音器

NT$56,000

RANE SEVENTY A-TRAK 混音器

NT$56,000

-

Numark Party Mix Live DJ ...

NT$5,580

Numark Party Mix Live DJ ...

NT$5,580

經典 MPC 靈魂回歸 / AKAI 新款MPC曝光

經典 MPC 靈魂回歸 / AKAI 新款MPC曝光  充滿懷舊風味的Casio 掌上型取樣器 – SX-C1

充滿懷舊風味的Casio 掌上型取樣器 – SX-C1  最強大的獨立音樂製作旗艦機

最強大的獨立音樂製作旗艦機  世界首款唱盤式獨立機種 – RANE SYSTEM ONE誕生

世界首款唱盤式獨立機種 – RANE SYSTEM ONE誕生  全新效果器 KAOSS Pad V 正式亮相

全新效果器 KAOSS Pad V 正式亮相  Oyaide Neo PA-08 DXM V2 (...

Oyaide Neo PA-08 DXM V2 (...  Oyaide Neo PA-08 DXF V2 (...

Oyaide Neo PA-08 DXF V2 (...  Akai Professional MPK Min...

Akai Professional MPK Min...  Akai Professional MPK Min...

Akai Professional MPK Min...  Presonus Eris Studio 4 監聽...

Presonus Eris Studio 4 監聽...  Presonus Eris Studio 5 監...

Presonus Eris Studio 5 監...  Presonus Eris 3.5 2nd Gen...

Presonus Eris 3.5 2nd Gen...  YAMAHA SEQTRAK 便攜式音樂創作工作站

YAMAHA SEQTRAK 便攜式音樂創作工作站

近期留言